理解模型评估中的准确率、精确率、召回率、特异性和F1分数

目录

- 模型评估指标介绍

- 混淆矩阵:基础

- 准确率:起点

- 精确率:衡量准确性

- 召回率(敏感度):衡量完整性

- 特异性:被低估的指标

- F1分数:平衡精确率和召回率

- 为您的模型选择合适的指标

- 利用Scikit-Learn计算指标

- 结论

模型评估指标介绍

在开发分类模型时,评估模型性能不仅仅依赖于整体准确率是至关重要的。不同的指标提供了模型性能各个方面的见解,帮助您根据应用的具体需求做出明智的决策。

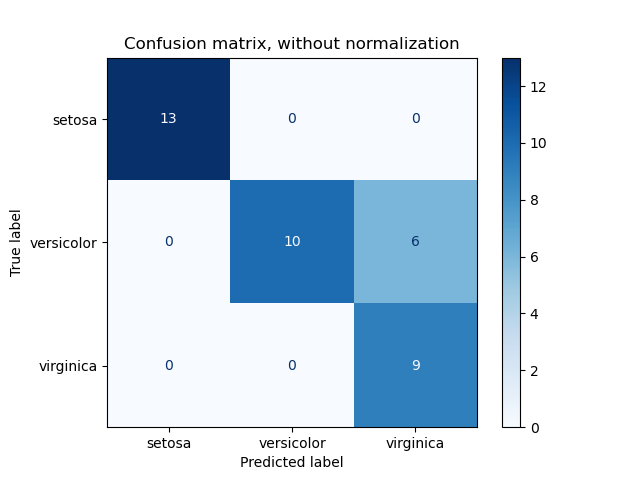

混淆矩阵:基础

混淆矩阵是一种表格,用于可视化分类模型的性能。它将实际的目标值与模型预测的值进行比较。对于二元分类,混淆矩阵是一个包含以下内容的2×2矩阵:

- 真正例 (TP): 正确预测为正类的实例。

- 假正例 (FP): 错误预测为正类的实例。

- 真负例 (TN): 正确预测为负类的实例。

- 假负例 (FN): 错误预测为负类的实例。

理解这些组成部分至关重要,因为它们构成了计算各种性能指标的基础。

准确率:起点

准确率是最直接的指标,表示总正确预测占所有预测的百分比。

公式:

\[ \text{Accuracy} = \frac{TP + TN}{TP + FP + FN + TN} \]

示例:

考虑一种情况,模型预测了10个真正例,9个真负例,并有少数错误预测:

\[ \text{Accuracy} = \frac{10 + 9}{10 + 9 + 0 + 0} = 97.5\% \]

虽然97.5%的准确率看起来令人印象深刻,但必须认识到其局限性,特别是在一个类别显著多于另一个类别的不平衡数据集中。

精确率:衡量准确性

精确率评估被预测为正类的实例中有多少实际上是正确的。它回答的问题是:当模型预测为正类时,正确的频率是多少?

公式:

\[ \text{Precision} = \frac{TP}{TP + FP} \]

示例:

使用同一个模型:

\[ \text{Precision} = \frac{10}{10 + 250} = 3.8\% \]

较低的精确率表示假正例的数量较多,这在假警报代价高昂的应用中可能会带来问题。

精确率的重要性:

在假正例代价高昂的情景中,如垃圾邮件检测或医学诊断,精确率至关重要。

召回率(敏感度):衡量完整性

召回率,也称为敏感度,衡量模型识别所有相关实例的能力。它回答的问题是:在所有实际的正实例中,模型正确识别了多少?

公式:

\[ \text{Recall} = \frac{TP}{TP + FN} \]

示例:

\[ \text{Recall} = \frac{10}{10 + 5} = 66.6\% \]

更高的召回率表明模型捕捉了更多的正类,这在如疾病筛查等应用中是可取的。

召回率的重要性:

在漏检正实例会带来严重后果的情况下,如疾病检测或安全威胁识别,召回率至关重要。

特异性:被低估的指标

特异性衡量实际负类中有多少被正确识别。它回答的问题是:在所有实际的负实例中,模型正确识别了多少?

公式:

\[ \text{Specificity} = \frac{TN}{TN + FP} \]

示例:

\[ \text{Specificity} = \frac{9990}{9990 + 250} = 97.55\% \]

高特异性表明模型在识别负实例方面有效,这在假负例特别不受欢迎的情景中起着关键作用。

特异性的重要性:

在准确识别负类至关重要的应用中,如欺诈检测或非疾病(健康)分类,特异性是必不可少的。

F1分数:平衡精确率和召回率

F1分数是精确率和召回率的调和平均数,提供了一个平衡这两者的单一指标。与算术平均不同,F1分数考虑了精确率和召回率之间的权衡。

公式:

\[ \text{F1 Score} = 2 \times \frac{\text{Precision} \times \text{Recall}}{\text{Precision} + \text{Recall}} \]

示例:

\[ \text{F1 Score} = 2 \times \frac{0.038 \times 0.666}{0.038 + 0.666} \approx 7.1\% \]

当需要在精确率和召回率之间取得平衡,尤其是在类别分布不均衡时,F1分数特别有用。

F1分数的重要性:

F1分数适用于需要同时最小化假正例和假负例的重要场景,提供了对模型性能更细致的视角。

为您的模型选择合适的指标

选择适当的评估指标取决于项目的具体需求和背景:

- 使用准确率,当类别平衡且所有错误的代价相同时。

- 使用精确率,当假正例的代价高时。

- 使用召回率,当假负例的代价高时。

- 使用特异性,当准确识别负类至关重要时。

- 使用F1分数,当需要在精确率和召回率之间取得平衡,尤其是在不平衡数据集时。

理解这些指标确保您选择与项目目标和限制相一致的合适指标。

利用Scikit-Learn计算指标

手动计算这些指标可能繁琐且容易出错,尤其是对于更复杂的模型。幸运的是,Python的Scikit-Learn库提供了强大的工具,可以轻松计算这些指标。

有用的Scikit-Learn函数:

accuracy_score:计算准确率。precision_score:计算精确率。recall_score:计算召回率。f1_score:计算F1分数。confusion_matrix:生成混淆矩阵。classification_report:提供包括上述所有指标的详细报告。

示例:

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 |

from sklearn.metrics import confusion_matrix, accuracy_score, precision_score, recall_score, f1_score # Assume y_true and y_pred are your actual and predicted labels conf_matrix = confusion_matrix(y_true, y_pred) accuracy = accuracy_score(y_true, y_pred) precision = precision_score(y_true, y_pred) recall = recall_score(y_true, y_pred) f1 = f1_score(y_true, y_pred) print("Confusion Matrix:\n", conf_matrix) print(f"Accuracy: {accuracy * 100:.2f}%") print(f"Precision: {precision * 100:.2f}%") print(f"Recall: {recall * 100:.2f}%") print(f"F1 Score: {f1 * 100:.2f}%") |

对于更高级的指标计算,包括特异性,您可以使用classification_report或探索更多的Scikit-Learn资源:

结论

评估分类模型的性能需要一种超越单纯准确率的细致方法。通过理解和利用精确率、召回率、特异性和F1分数等指标,您可以更深入地了解模型的优势和劣势。这种全面的评估确保您的模型在现实世界场景中表现最佳,符合项目的具体目标和需求。

请记住,指标的选择应始终以应用的上下文为指导。利用如Scikit-Learn这样的工具简化这一过程,让您能够专注于优化模型以获得最佳结果。

关键词:准确率、精确率、召回率、特异性、F1分数、混淆矩阵、模型评估、机器学习指标、Scikit-Learn、分类模型性能。