html

Compreendendo Acurácia, Precisão, Recall, Especificidade e F1 Score na Avaliação de Modelos

Tabela de Conteúdos

- Introdução às Métricas de Avaliação de Modelos

- Matriz de Confusão: A Base

- Acurácia: O Ponto de Partida

- Precisão: Medindo a Exatidão

- Recall (Sensibilidade): Medindo a Completude

- Especificidade: A Métrica Subestimada

- F1 Score: Equilibrando Precisão e Recall

- Escolhendo a Métrica Certa para Seu Modelo

- Aproveitando o Scikit-Learn para o Cálculo de Métricas

- Conclusão

Introdução às Métricas de Avaliação de Modelos

Ao desenvolver modelos de classificação, é crucial avaliar quão bem seu modelo performa além da simples acurácia geral. Diferentes métricas fornecem insights sobre vários aspectos do desempenho do seu modelo, ajudando você a tomar decisões informadas com base nas necessidades específicas de sua aplicação.

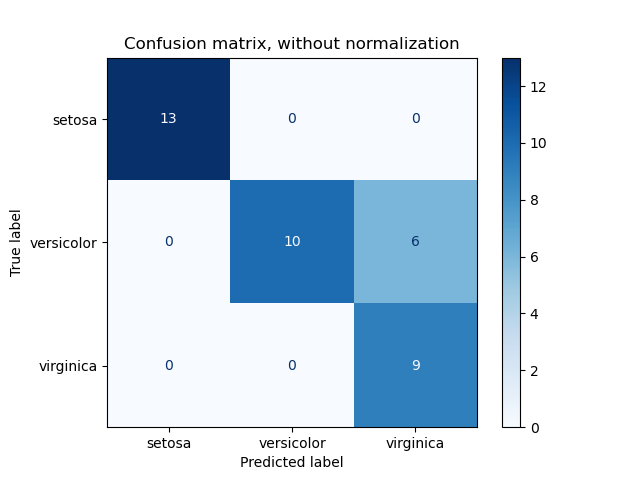

Matriz de Confusão: A Base

Uma Matriz de Confusão é uma tabela que permite visualizar o desempenho de um modelo de classificação. Ela compara os valores reais do alvo com aqueles previstos pelo modelo. Para classificação binária, a matriz de confusão é uma matriz 2x2 que contém:

- Verdadeiros Positivos (TP): Instâncias positivas previstas corretamente.

- Falsos Positivos (FP): Instâncias positivas previstas incorretamente.

- Verdadeiros Negativos (TN): Instâncias negativas previstas corretamente.

- Falsos Negativos (FN): Instâncias negativas previstas incorretamente.

Compreender esses componentes é essencial, pois eles formam a base para calcular várias métricas de desempenho.

Acurácia: O Ponto de Partida

Acurácia é a métrica mais direta, representando a porcentagem de previsões corretas totais em relação a todas as previsões feitas.

Fórmula:

\[ \text{Acurácia} = \frac{TP + TN}{TP + FP + FN + TN} \]

Exemplo:

Considere um cenário em que um modelo prevê 10 verdadeiros positivos, 9 verdadeiros negativos e tem algumas previsões incorretas:

\[ \text{Acurácia} = \frac{10 + 9}{10 + 9 + 0 + 0} = 97,5\% \]

Embora uma acurácia de 97,5% pareça impressionante, é essencial reconhecer suas limitações, especialmente em casos de conjuntos de dados desequilibrados onde uma classe supera significativamente a outra.

Precisão: Medindo a Exatidão

Precisão avalia quantas das instâncias previstas como positivas estão realmente corretas. Ela responde à pergunta: Quando o modelo prevê uma classe positiva, com que frequência ele está correto?

Fórmula:

\[ \text{Precisão} = \frac{TP}{TP + FP} \]

Exemplo:

Usando o mesmo modelo:

\[ \text{Precisão} = \frac{10}{10 + 250} = 3,8\% \]

Uma baixa precisão indica um alto número de falsos positivos, o que pode ser problemático em aplicações onde alarmes falsos são custosos.

Importância da Precisão:

A precisão é crucial em cenários onde o custo de falsos positivos é alto, como detecção de spam ou diagnósticos médicos.

Recall (Sensibilidade): Medindo a Completude

Recall, também conhecido como Sensibilidade, mede a capacidade do modelo de identificar todas as instâncias relevantes. Ele responde à pergunta: De todas as instâncias positivas reais, quantas o modelo identificou corretamente?

Fórmula:

\[ \text{Recall} = \frac{TP}{TP + FN} \]

Exemplo:

\[ \text{Recall} = \frac{10}{10 + 5} = 66,6\% \]

Um recall mais alto indica que o modelo está capturando uma porção maior da classe positiva, o que é desejável em aplicações como triagem de doenças.

Importância do Recall:

O recall é vital em situações onde perder uma instância positiva tem consequências graves, como na detecção de doenças ou identificação de ameaças de segurança.

Especificidade: A Métrica Subestimada

Especificidade mede a proporção de negativos reais que são corretamente identificados. Ela responde à pergunta: De todas as instâncias negativas reais, quantas o modelo reconheceu corretamente?

Fórmula:

\[ \text{Especificidade} = \frac{TN}{TN + FP} \]

Exemplo:

\[ \text{Especificidade} = \frac{9990}{9990 + 250} = 97,55\% \]

Alta especificidade indica que o modelo é eficaz em identificar instâncias negativas, o que é crucial em cenários onde falsos negativos são particularmente indesejáveis.

Importância da Especificidade:

Especificidade é essencial em aplicações onde identificar com precisão a classe negativa é crítico, como na detecção de fraudes ou classificações de não-doença (saudáveis).

F1 Score: Equilibrando Precisão e Recall

O F1 Score é a média harmônica da precisão e do recall, fornecendo uma única métrica que equilibra ambas as preocupações. Diferentemente da média aritmética, o F1 Score considera a compensação entre precisão e recall.

Fórmula:

\[ \text{F1 Score} = 2 \times \frac{\text{Precisão} \times \text{Recall}}{\text{Precisão} + \text{Recall}} \]

Exemplo:

\[ \text{F1 Score} = 2 \times \frac{0,038 \times 0,666}{0,038 + 0,666} \approx 7,1\% \]

O F1 Score é particularmente útil quando você precisa de um equilíbrio entre precisão e recall e quando há uma distribuição desigual das classes.

Importância do F1 Score:

O F1 Score é ideal para situações onde tanto falsos positivos quanto falsos negativos são importantes para minimizar, oferecendo uma visão mais detalhada do desempenho do modelo.

Escolhendo a Métrica Certa para Seu Modelo

Selecionar a métrica de avaliação apropriada depende dos requisitos específicos e do contexto do seu projeto:

- Use Acurácia quando as classes estão balanceadas e todos os erros têm custos iguais.

- Use Precisão quando o custo de falsos positivos é alto.

- Use Recall quando o custo de falsos negativos é alto.

- Use Especificidade quando identificar corretamente a classe negativa é crucial.

- Use F1 Score quando você precisar de um equilíbrio entre precisão e recall, especialmente em conjuntos de dados desbalanceados.

Compreender essas métricas garante que você escolha a certa para alinhar com os objetivos e restrições do seu projeto.

Aproveitando o Scikit-Learn para o Cálculo de Métricas

Calcular manualmente essas métricas pode ser tedioso e propenso a erros, especialmente para modelos mais complexos. Felizmente, a biblioteca Scikit-Learn do Python oferece ferramentas robustas para calcular essas métricas sem esforço.

Funções Úteis do Scikit-Learn:

accuracy_score: Calcula a acurácia.

precision_score: Calcula a precisão.

recall_score: Calcula o recall.

f1_score: Calcula o F1 Score.

confusion_matrix: Gera a matriz de confusão.

classification_report: Fornece um relatório detalhado incluindo todas as métricas acima.

Exemplo:

1234567891011121314

from sklearn.metrics import confusion_matrix, accuracy_score, precision_score, recall_score, f1_score # Assume y_true and y_pred are your actual and predicted labelsconf_matrix = confusion_matrix(y_true, y_pred)accuracy = accuracy_score(y_true, y_pred)precision = precision_score(y_true, y_pred)recall = recall_score(y_true, y_pred)f1 = f1_score(y_true, y_pred) print("Confusion Matrix:\n", conf_matrix)print(f"Accuracy: {accuracy * 100:.2f}%")print(f"Precision: {precision * 100:.2f}%")print(f"Recall: {recall * 100:.2f}%")print(f"F1 Score: {f1 * 100:.2f}%")

Para cálculos de métricas mais avançados, incluindo especificidade, você pode utilizar o classification_report ou explorar recursos adicionais do Scikit-Learn:

Conclusão

Avaliar o desempenho de um modelo de classificação requer uma abordagem nuançada que vai além da mera acurácia. Ao compreender e utilizar métricas como Precisão, Recall, Especificidade e o F1 Score, você obtém insights mais profundos sobre os pontos fortes e fracos do seu modelo. Essa avaliação abrangente garante que seu modelo desempenhe de forma otimizada em cenários do mundo real, alinhando-se com os objetivos e requisitos específicos do seu projeto.

Lembre-se, a escolha da métrica deve sempre ser guiada pelo contexto da sua aplicação. Utilize ferramentas como o Scikit-Learn para simplificar esse processo, permitindo que você se concentre em refinar seus modelos para os melhores resultados possíveis.

Palavras-chave: Acurácia, Precisão, Recall, Especificidade, F1 Score, Matriz de Confusão, Avaliação de Modelos, Métricas de Machine Learning, Scikit-Learn, Desempenho de Modelo de Classificação.