html

모델 평가에서 정확도, 정밀도, 재현율, 특이도, 그리고 F1 점수 이해하기

목차

- 모델 평가 지표 소개

- 혼동 행렬: 기초

- 정확도: 출발점

- 정밀도: 정확성 측정

- 재현율 (민감도): 완전성 측정

- 특이도: 과소평가된 지표

- F1 점수: 정밀도와 재현율의 균형

- 모델에 적합한 지표 선택하기

- 지표 계산을 위한 Scikit-Learn 활용

- 결론

모델 평가 지표 소개

분류 모델을 개발할 때, 전체 정확도뿐만 아니라 모델의 성능을 평가하는 것이 중요합니다. 다양한 지표는 모델 성능의 여러 측면에 대한 통찰을 제공하여, 애플리케이션의 특정 요구 사항에 따라 정보에 입각한 결정을 내리는 데 도움이 됩니다.

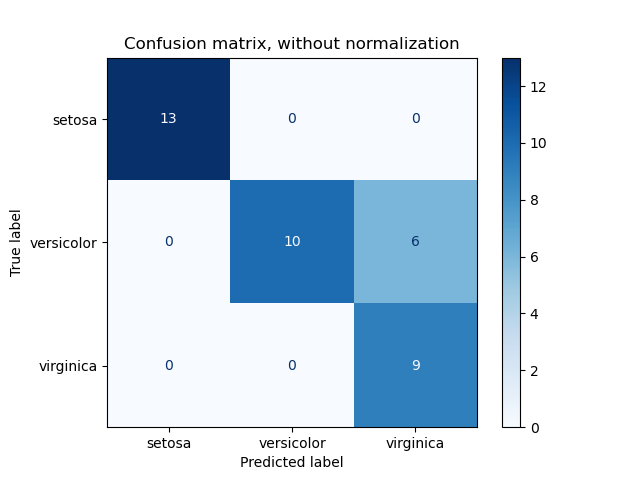

혼동 행렬: 기초

혼동 행렬은 분류 모델의 성능을 시각화할 수 있는 표입니다. 실제 타겟 값과 모델이 예측한 값을 비교합니다. 이진 분류의 경우, 혼동 행렬은 다음을 포함하는 2x2 행렬입니다:

- True Positives (TP): 올바르게 예측된 양성 사례.

- False Positives (FP): 잘못 예측된 양성 사례.

- True Negatives (TN): 올바르게 예측된 음성 사례.

- False Negatives (FN): 잘못 예측된 음성 사례.

이 구성 요소를 이해하는 것은 다양한 성능 지표를 계산하는 기초가 되기 때문에 필수적입니다.

정확도: 출발점

정확도는 가장 간단한 지표로, 전체 예측 중 올바르게 예측된 비율을 나타냅니다.

공식:

\[ \text{Accuracy} = \frac{TP + TN}{TP + FP + FN + TN} \]

예제:

모델이 10개의 True Positives, 9개의 True Negatives를 예측하고 몇몇 잘못된 예측이 있다고 가정해 보겠습니다:

\[ \text{Accuracy} = \frac{10 + 9}{10 + 9 + 0 + 0} = 97.5\% \]

97.5%의 정확도는 인상적으로 보일 수 있지만, 한 클래스가 다른 클래스를 현저히 능가하는 불균형한 데이터셋의 경우 그 한계를 인식하는 것이 중요합니다.

정밀도: 정확성 측정

정밀도는 양성으로 예측된 사례 중 실제로 얼마나 많은 비율이 정확한지를 평가합니다. 이는 다음 질문에 답합니다: 모델이 양성 클래스를 예측할 때, 얼마나 자주 정확한가요?

공식:

\[ \text{Precision} = \frac{TP}{TP + FP} \]

예제:

같은 모델을 사용하여:

\[ \text{Precision} = \frac{10}{10 + 250} = 3.8\% \]

낮은 정밀도는 많은 수의 False Positives를 나타내며, 이는 거짓 경보가 비용이 많이 드는 애플리케이션에서 문제가 될 수 있습니다.

정밀도의 중요성:

정밀도는 스팸 감지나 의료 진단과 같이 False Positives의 비용이 높은 시나리오에서 중요합니다.

재현율 (민감도): 완전성 측정

재현율, 또는 민감도는 모든 관련 사례를 식별하는 모델의 능력을 측정합니다. 이는 다음 질문에 답합니다: 실제 양성 사례 중 모델이 얼마나 많이 정확하게 식별했나요?

공식:

\[ \text{Recall} = \frac{TP}{TP + FN} \]

예제:

\[ \text{Recall} = \frac{10}{10 + 5} = 66.6\% \]

높은 재현율은 모델이 양성 클래스를 더 많이 포착하고 있음을 나타내며, 이는 질병 스크리닝과 같은 애플리케이션에서 바람직합니다.

재현율의 중요성:

재현율은 질병 감지나 보안 위협 식별과 같이 양성 사례를 놓치는 것이 심각한 결과를 초래할 수 있는 상황에서 필수적입니다.

특이도: 과소평가된 지표

특이도는 실제 음성 사례 중 얼마나 많은 비율을 정확하게 식별했는지를 측정합니다. 이는 다음 질문에 답합니다: 실제 음성 사례 중 모델이 얼마나 많이 정확하게 인식했나요?

공식:

\[ \text{Specificity} = \frac{TN}{TN + FP} \]

예제:

\[ \text{Specificity} = \frac{9990}{9990 + 250} = 97.55\% \]

높은 특이도는 모델이 음성 사례를 효과적으로 식별하고 있음을 나타내며, 이는 False Negatives가 특히 바람직하지 않은 시나리오에서 중요합니다.

특이도의 중요성:

특이도는 사기 탐지나 비질병(건강) 분류와 같이 음성 클래스를 정확하게 식별하는 것이 중요한 애플리케이션에서 필수적입니다.

F1 점수: 정밀도와 재현율의 균형

F1 점수는 정밀도와 재현율의 조화 평균으로, 두 가지 측면을 균형 있게 고려하는 단일 지표를 제공합니다. 산술 평균과 달리, F1 점수는 정밀도와 재현율 간의 균형을 반영합니다.

공식:

\[ \text{F1 Score} = 2 \times \frac{\text{Precision} \times \text{Recall}}{\text{Precision} + \text{Recall}} \]

예제:

\[ \text{F1 Score} = 2 \times \frac{0.038 \times 0.666}{0.038 + 0.666} \approx 7.1\% \]

F1 점수는 정밀도와 재현율 사이의 균형이 필요하고 클래스 분포가 불균형한 경우에 특히 유용합니다.

F1 점수의 중요성:

F1 점수는 False Positives와 False Negatives를 모두 최소화하는 것이 중요한 상황에서 모델 성능에 대한 더 세밀한 관점을 제공하여 이상적입니다.

모델에 적합한 지표 선택하기

적절한 평가 지표를 선택하는 것은 프로젝트의 특정 요구 사항과 맥락에 따라 다릅니다:

- 정확도 사용: 클래스가 균형을 이루고 모든 오류의 비용이 동일할 때.

- 정밀도 사용: False Positives의 비용이 높을 때.

- 재현율 사용: False Negatives의 비용이 높을 때.

- 특이도 사용: 음성 클래스를 정확하게 식별하는 것이 중요할 때.

- F1 점수 사용: 정밀도와 재현율 사이의 균형이 필요할 때, 특히 불균형한 데이터셋에서.

이러한 지표를 이해하면 프로젝트의 목표와 제약 조건에 맞는 올바른 지표를 선택할 수 있습니다.

지표 계산을 위한 Scikit-Learn 활용

이러한 지표를 수동으로 계산하는 것은 지루하고 오류가 발생하기 쉬우며, 특히 더 복잡한 모델의 경우 더욱 그렇습니다. 다행히도, Python의 Scikit-Learn 라이브러리는 이 지표들을 손쉽게 계산할 수 있는 강력한 도구를 제공합니다.

유용한 Scikit-Learn 함수:

accuracy_score: 정확도를 계산합니다.

precision_score: 정밀도를 계산합니다.

recall_score: 재현율을 계산합니다.

f1_score: F1 점수를 계산합니다.

confusion_matrix: 혼동 행렬을 생성합니다.

classification_report: 위의 모든 지표를 포함한 자세한 보고서를 제공합니다.

예제:

1234567891011121314

from sklearn.metrics import confusion_matrix, accuracy_score, precision_score, recall_score, f1_score # Assume y_true and y_pred are your actual and predicted labelsconf_matrix = confusion_matrix(y_true, y_pred)accuracy = accuracy_score(y_true, y_pred)precision = precision_score(y_true, y_pred)recall = recall_score(y_true, y_pred)f1 = f1_score(y_true, y_pred) print("Confusion Matrix:\n", conf_matrix)print(f"Accuracy: {accuracy * 100:.2f}%")print(f"Precision: {precision * 100:.2f}%")print(f"Recall: {recall * 100:.2f}%")print(f"F1 Score: {f1 * 100:.2f}%")

더 고급의 지표 계산, 특히 특이도를 포함하려면 classification_report를 활용하거나 추가적인 Scikit-Learn 리소스를 탐색할 수 있습니다:

결론

분류 모델의 성능을 평가하는 것은 단순한 정확도를 넘어서는 세밀한 접근이 필요합니다. 정밀도, 재현율, 특이도, 그리고 F1 점수와 같은 지표를 이해하고 활용함으로써, 모델의 강점과 약점에 대한 깊은 통찰을 얻을 수 있습니다. 이러한 종합적인 평가를 통해 모델이 실제 상황에서 최적으로 작동하도록 보장하며, 프로젝트의 특정 목표와 요구 사항에 부합하도록 할 수 있습니다.

항상 지표 선택은 애플리케이션의 맥락에 의해 안내되어야 합니다. Scikit-Learn과 같은 도구를 활용하여 이 과정을 간소화하고, 최상의 결과를 위해 모델을 다듬는 데 집중할 수 있습니다.

키워드: 정확도, 정밀도, 재현율, 특이도, F1 점수, 혼동 행렬, 모델 평가, 머신 러닝 지표, Scikit-Learn, 분류 모델 성능.