html

Entendiendo la Precisión, Exactitud, Sensibilidad, Especificidad y el Puntaje F1 en la Evaluación de Modelos

Tabla de Contenidos

- Introducción a las Métricas de Evaluación de Modelos

- Matriz de Confusión: La Fundación

- Exactitud: El Punto de Partida

- Precisión: Midiendo la Exactitud

- Sensibilidad (Recall): Midiendo la Completitud

- Especificidad: La Métrica Subvalorada

- Puntaje F1: Equilibrando Precisión y Recall

- Eligiendo la Métrica Adecuada para tu Modelo

- Aprovechando Scikit-Learn para el Cálculo de Métricas

- Conclusión

Introducción a las Métricas de Evaluación de Modelos

Al desarrollar modelos de clasificación, es crucial evaluar cómo de bien funciona tu modelo más allá de la exactitud general. Diferentes métricas proporcionan información sobre varios aspectos del rendimiento de tu modelo, ayudándote a tomar decisiones informadas basadas en las necesidades específicas de tu aplicación.

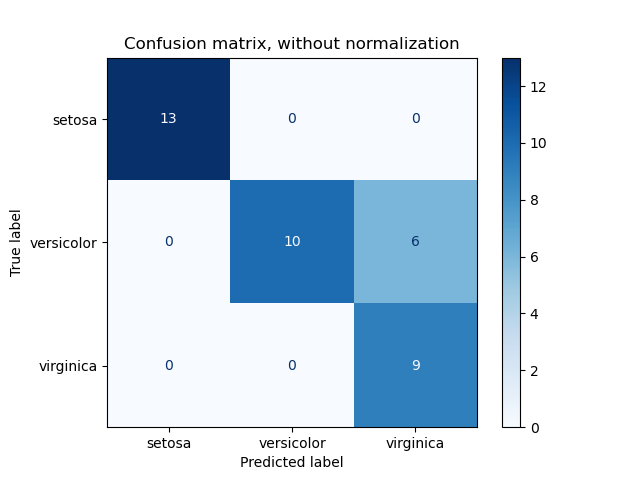

Matriz de Confusión: La Fundación

Una Matriz de Confusión es una tabla que permite visualizar el rendimiento de un modelo de clasificación. Compara los valores objetivos reales con los predichos por el modelo. Para la clasificación binaria, la matriz de confusión es una matriz 2x2 que contiene:

- Verdaderos Positivos (TP): Instancias positivas predichas correctamente.

- Falsos Positivos (FP): Instancias positivas incorrectamente predichas.

- Verdaderos Negativos (TN): Instancias negativas predichas correctamente.

- Falsos Negativos (FN): Instancias negativas incorrectamente predichas.

Entender estos componentes es esencial ya que forman la base para calcular varias métricas de rendimiento.

Exactitud: El Punto de Partida

Exactitud es la métrica más simple, que representa el porcentaje de predicciones correctas totales sobre todas las predicciones realizadas.

Fórmula:

\[ \text{Accuracy} = \frac{TP + TN}{TP + FP + FN + TN} \]

Ejemplo:

Considera un escenario donde un modelo predice 10 verdaderos positivos, 9 verdaderos negativos y tiene algunas predicciones falsas:

\[ \text{Accuracy} = \frac{10 + 9}{10 + 9 + 0 + 0} = 97.5\% \]

Mientras una exactitud del 97.5% parece impresionante, es esencial reconocer sus limitaciones, especialmente en casos de conjuntos de datos desequilibrados donde una clase supera significativamente a la otra.

Precisión: Midiendo la Exactitud

Precisión evalúa cuántas de las instancias predichas como positivas son realmente correctas. Responde a la pregunta: Cuando el modelo predice una clase positiva, ¿con qué frecuencia es correcto?

Fórmula:

\[ \text{Precision} = \frac{TP}{TP + FP} \]

Ejemplo:

Usando el mismo modelo:

\[ \text{Precision} = \frac{10}{10 + 250} = 3.8\% \]

Una baja precisión indica un alto número de falsos positivos, lo cual puede ser problemático en aplicaciones donde las falsas alarmas son costosas.

Importancia de la Precisión:

La precisión es crucial en escenarios donde el costo de los falsos positivos es alto, como en la detección de spam o diagnósticos médicos.

Sensibilidad (Recall): Midiendo la Completitud

Recall, también conocida como Sensibilidad, mide la capacidad del modelo para identificar todas las instancias relevantes. Responde a la pregunta: De todas las instancias positivas reales, ¿cuántas identificó correctamente el modelo?

Fórmula:

\[ \text{Recall} = \frac{TP}{TP + FN} \]

Ejemplo:

\[ \text{Recall} = \frac{10}{10 + 5} = 66.6\% \]

Un recall más alto indica que el modelo está capturando una mayor porción de la clase positiva, lo cual es deseable en aplicaciones como el cribado de enfermedades.

Importancia del Recall:

El recall es vital en situaciones donde omitir una instancia positiva tiene consecuencias graves, como en la detección de enfermedades o la identificación de amenazas de seguridad.

Especificidad: La Métrica Subvalorada

Especificidad mide la proporción de negativos reales que son correctamente identificados. Responde a la pregunta: De todas las instancias negativas reales, ¿cuántas reconoció correctamente el modelo?

Fórmula:

\[ \text{Specificity} = \frac{TN}{TN + FP} \]

Ejemplo:

\[ \text{Specificity} = \frac{9990}{9990 + 250} = 97.55\% \]

Una alta especificidad indica que el modelo es efectivo para identificar instancias negativas, lo cual es crucial en escenarios donde los falsos negativos son particularmente indeseables.

Importancia de la Especificidad:

La especificidad es esencial en aplicaciones donde identificar con precisión la clase negativa es crítico, como en la detección de fraudes o clasificaciones de no enfermedad (saludables).

Puntaje F1: Equilibrando Precisión y Recall

El Puntaje F1 es la media armónica de precisión y recall, proporcionando una métrica única que equilibra ambas preocupaciones. A diferencia de la media aritmética, el Puntaje F1 tiene en cuenta la compensación entre precisión y recall.

Fórmula:

\[ \text{F1 Score} = 2 \times \frac{\text{Precision} \times \text{Recall}}{\text{Precision} + \text{Recall}} \]

Ejemplo:

\[ \text{F1 Score} = 2 \times \frac{0.038 \times 0.666}{0.038 + 0.666} \approx 7.1\% \]

El Puntaje F1 es particularmente útil cuando necesitas un equilibrio entre precisión y recall y cuando hay una distribución desigual de clases.

Importancia del Puntaje F1:

El Puntaje F1 es ideal para situaciones donde tanto los falsos positivos como los falsos negativos son importantes de minimizar, proporcionando una vista más matizada del rendimiento del modelo.

Eligiendo la Métrica Adecuada para tu Modelo

Seleccionar la métrica de evaluación apropiada depende de los requisitos específicos y el contexto de tu proyecto:

- Usa Exactitud cuando las clases están equilibradas y todos los errores tienen el mismo costo.

- Usa Precisión cuando el costo de los falsos positivos es alto.

- Usa Recall cuando el costo de los falsos negativos es alto.

- Usa Especificidad cuando identificar correctamente la clase negativa es crucial.

- Usa Puntaje F1 cuando necesitas un equilibrio entre precisión y recall, especialmente en conjuntos de datos desbalanceados.

Entender estas métricas asegura que elijas la adecuada para alinearla con los objetivos y limitaciones de tu proyecto.

Aprovechando Scikit-Learn para el Cálculo de Métricas

Calcular estas métricas manualmente puede ser tedioso y propenso a errores, especialmente para modelos más complejos. Afortunadamente, la biblioteca Scikit-Learn de Python ofrece herramientas robustas para calcular estas métricas sin esfuerzo.

Funciones Útiles de Scikit-Learn:

accuracy_score: Calcula la exactitud.

precision_score: Calcula la precisión.

recall_score: Calcula el recall.

f1_score: Calcula el Puntaje F1.

confusion_matrix: Genera la matriz de confusión.

classification_report: Proporciona un informe detallado que incluye todas las métricas anteriores.

Ejemplo:

1234567891011121314

from sklearn.metrics import confusion_matrix, accuracy_score, precision_score, recall_score, f1_score # Assume y_true and y_pred are your actual and predicted labelsconf_matrix = confusion_matrix(y_true, y_pred)accuracy = accuracy_score(y_true, y_pred)precision = precision_score(y_true, y_pred)recall = recall_score(y_true, y_pred)f1 = f1_score(y_true, y_pred) print("Confusion Matrix:\n", conf_matrix)print(f"Accuracy: {accuracy * 100:.2f}%")print(f"Precision: {precision * 100:.2f}%")print(f"Recall: {recall * 100:.2f}%")print(f"F1 Score: {f1 * 100:.2f}%")

Para cálculos de métricas más avanzadas, incluyendo la especificidad, puedes utilizar el classification_report o explorar recursos adicionales de Scikit-Learn:

Conclusión

Evaluar el rendimiento de un modelo de clasificación requiere un enfoque matizado que vaya más allá de la mera exactitud. Al entender y aprovechar métricas como Precisión, Recall, Especificidad y el Puntaje F1, obtienes una comprensión más profunda de las fortalezas y debilidades de tu modelo. Esta evaluación integral asegura que tu modelo funcione de manera óptima en escenarios del mundo real, alineándose con los objetivos y requisitos específicos de tu proyecto.

Recuerda, la elección de la métrica siempre debe estar guiada por el contexto de tu aplicación. Utiliza herramientas como Scikit-Learn para agilizar este proceso, lo que te permitirá enfocarte en refinar tus modelos para obtener los mejores resultados posibles.

Palabras clave: Exactitud, Precisión, Recall, Especificidad, Puntaje F1, Matriz de Confusión, Evaluación de Modelos, Métricas de Machine Learning, Scikit-Learn, Rendimiento del Modelo de Clasificación.